Mithilfe von LTE und Glasfasertechnik wird unser Leben noch stärker digital stattfinden. Netzbetreiber sehen sich mit wachsenden Datenaufkommen und steigenden Kundenansprüchen konfrontiert. Gleichzeitig gilt es, die Herausforderungen des wirtschaftlichen Wandels zur Industrie 4.0 zu bewältigen. Wer sich gut für die Zukunft rüsten möchte, braucht einen starken Partner an seiner Seite.

F***ing change a running system.

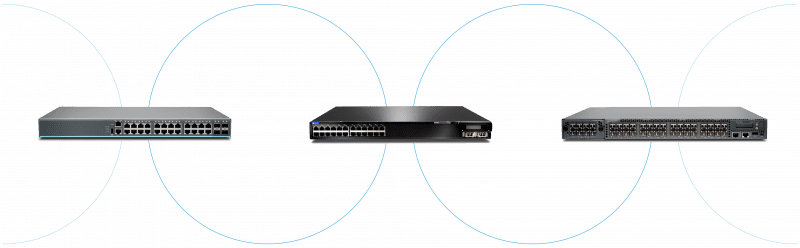

Die HCD Consulting GmbH ist Ihr Partner, wenn es um IT-Netzwerk-Lösungen geht. Unser Erfolg stützt sich auf ein sorgfältig abgestimmtes Hersteller-Portfolio und leistungsstarke Kunden, denen wir das erforderliche Know-how sowie alle nötigen Ressourcen zur Verfügung stellen, um neue Geschäftsfelder erfolgreich zu erschließen.

English

English