NVIDIA Networking InfiniBand

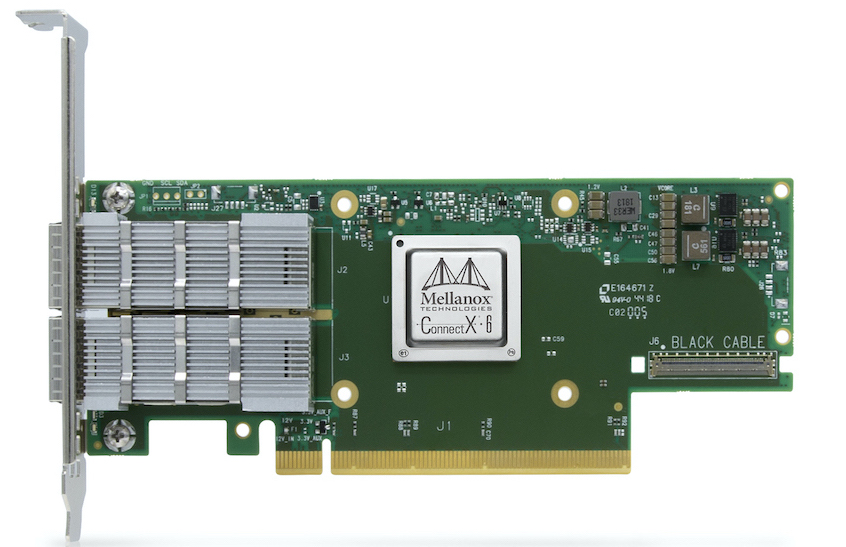

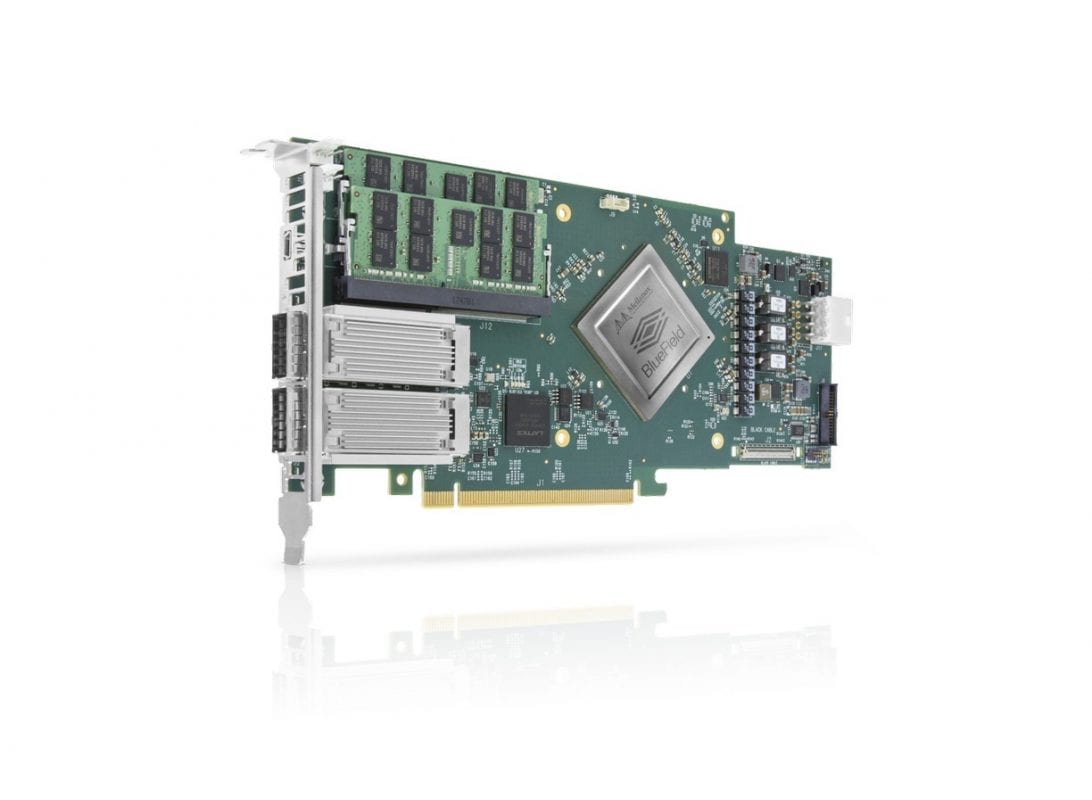

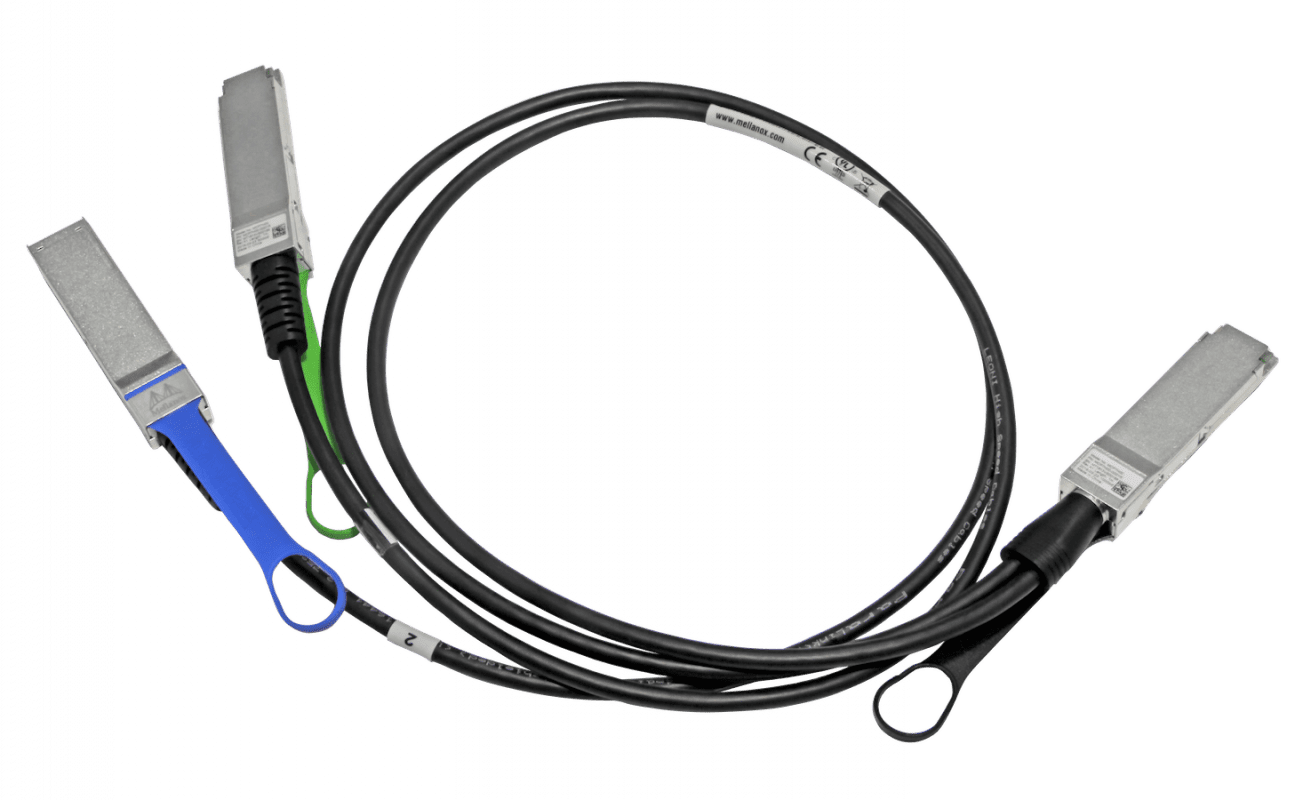

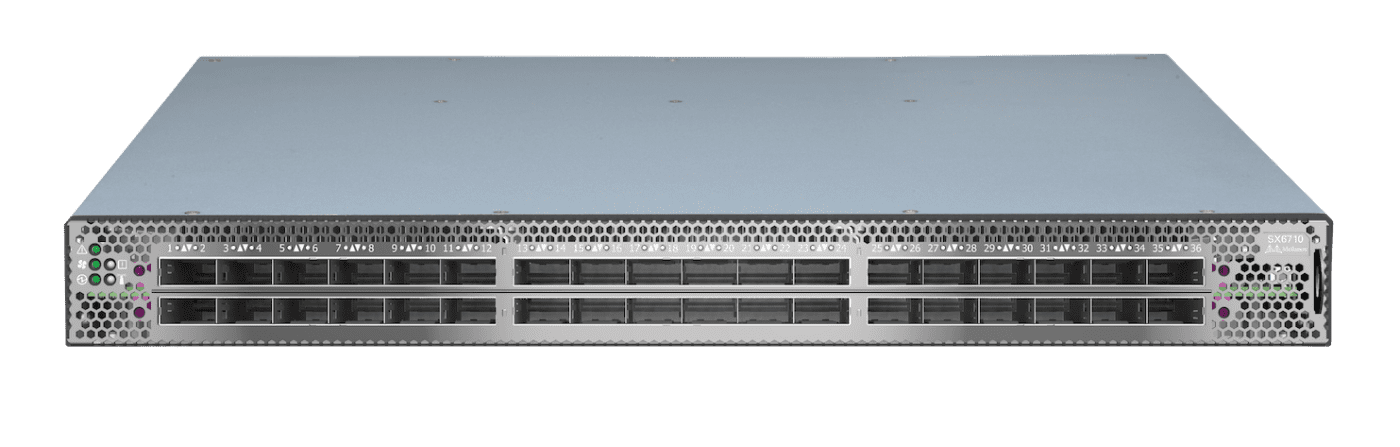

Als weltweit führender Hersteller von InfiniBand Produkten bietet NVIDIA Networking die beste Performance für Ihre Machine Learning, High Performance Computing und Datenbank Plattformen. Besonders Latenz-kritische Systeme profitieren von den InfiniBand Netzen. Durch den Fokus auf Interkonnektivität, Multi-Host-Umgebungen und die Unterstützung von unterschiedlichen Formfaktoren bietet NVIDIA Networking die perfekte Lösung für jedes Rechenzentrum.

English

English