Ergänzung Dezember 2020: Mellanox wurde von NVIDIA übernommen und bildet nun zusammen mit Cumulus die Sparte NVIDIA Networking. Mehr dazu lesen Sie hier.

Seit der Gründung im Jahr 1999 ist Mellanox von einem Hersteller für IC-Mikrochips zum weltweit führenden Hersteller für End-to-End InfiniBand- und Ethernetlösungen im Bereich High-Performance Computing, Data Center und Storage aufgestiegen. Ab sofort ergänzt der Hersteller das Portfolio der HCD Consulting im Bereich Data Center und Netzwerk.

Der Erfolg von Mellanox begründet sich aus der Entwicklung eigener ASIC-Chips, denn durch die vollständige Eigenentwicklung aller Komponenten sind Hard- und Software ideal aufeinander abgestimmt. Dies führt nicht nur zu besserer Performance, sondern auch zu niedrigeren Preisen, weniger benötigter Hardware und somit auch zu geringerem Rohstoff- und Stromverbrauch – und folglich einem kleineren ökologischen Fußabdruck. Mellanox Hardware ist daher perfekt auf die Erfordernisse im Bereich High Performance Computing angepasst.

Mellanox bietet End-to-End Lösungen

Als End-to-End Hersteller vertreibt Mellanox alle Komponenten, die für ein leistungs- und zukunftsfähiges Rechenzentrum notwendig sind. Die ConnectX Produktfamilie bietet Multi-Protokoll Netzwerkkarten ICs, die Geschwindigkeiten von bis zu 200 Gb/s – über InfiniBand und Ethernet – bereitstellen können. Die BlueField IPUs bieten darüber hinaus weitere Optionen für Individuallösungen durch die Integration von 64-bit Arm Prozessoren. Die Netzwerkkarten werden von Switching, Kabel und Transceiver Produkten ergänzt, die eine End-zu-End-Lösung aus einer Hand erlauben. Die Produkte von Mellanox sind auch mit den Ethernet Produkten aller führender Anbieter kompatibel, sodass auch Multi-Vendor-Umgebungen realisiert werden können.

Konvergierende Netzwerke sind die Zukunft

Während die InfiniBand Technologie bisher die besten Resultate für die Vernetzung innerhalb von Rechenzentren geliefert hat, wird es immer wichtiger, in Richtung konvergierender Netzwerke zu denken, um den Anforderungen der Zukunft gewachsen zu sein. Rechenzentren werden immer weniger in abgeschlossenen Daten-Silos gedacht, sondern müssen flexibel skalierbar und mit Internet oder Cloud Umgebungen eng verknüpft sein. Aus diesem Grund geht auch in Rechenzentren der Fokus zunehmend zu Ethernet bzw. Multi-Protokoll Netzwerken, auch wenn InfiniBand durch seine niedrigen Latenzen und verlustfreie Übertragung weiterhin relevant bleibt.

Um den Anforderungen der konvergierenden Netze gerecht zu werden, kommt bei Mellanox die Virtual Protokoll Interconnect (VPI) Technologie zum Einsatz. Sie erlaubt es eine Vielzahl von Kommunikationsprotokollen und Netzwerk-Fabrics nebeneinander zu betreiben. Jeder Port der ConnectX-Karten kann unabhängig in einem InfiniBand oder Ethernet-Netzwerk betrieben werden. Dies ermöglicht flexible und heterogene Strukturen, die den momentanen Bedürfnissen flexibel angepasst werden können.

Neben VPI unterstützen die Netzwerkadapter auch die Multi-Host-Technologie von Mellanox. Diese ermöglicht es multiple Compute- und Storage-Hosts in einem einzigen Adapter zu verbinden. Die Multi-Host Technologie ermöglicht dabei die Trennung des Adapter PCIe Interface in multiple Interfaces, die sich zu separaten Host-CPUs verbinden lassen. Somit lassen sich Scale-out Compute und Storage Racks mit einer direkten Verbindung der Compute-, Speicher- und Netzwerkkomponenten umsetzen, die das Maximum an Rechenleistung und Datentransferraten bieten.

Bessere HPC Performance durch Offloading

Ein weiterer Vorteil der ConnectX Serie von Mellanox sind die Offloading Kapazitäten, die ebenfalls für InfiniBand und Ethernet genutzt werden können. Hierzu gehören die Implementierung von RDMA und RoCE (RDMA over Converged Ethernet). Dabei werden verschiedene Protokolle wie iSCSI over RDMA (iSER), NFS RDMA, SMB Direct und NVMe over Fabric unterstützt. Ebenfalls kann die PeerDirect Technologie mit NVIDIA GPUDirect RDMA für GPU-lastiges Computing genutzt werden. Die neueste Generation der ConnectX ICs unterstützt IPsec, TLS Inline Data-In-Motion Encryption und AESXTS Block Level Encryption, sodass auch Sicherheitsaufgaben von den Adaptern übernommen werden können. Die Netzwerkkarten mit den BlueField IPUs sind um Arm Prozessoren erweitert und können darüber hinaus noch weitere, spezialisierte Offload Aufgaben übernehmen.

Das Portfolio von Mellanox

Netzwerkkarten (NICs)

Die Netzwerkkarten von Mellanox sind in einer Vielzahl von Formfaktoren erhältlich, inklusive Open Compute Project (OCP) Karten und Socket Direct Adapter Karten.

ConnectX SmartNICs

Die intelligenten Netzwerkkarten von Mellanox bieten durch die ConnectX ASICs nicht nur hohe Datenraten, sondern auch Offload Kapaziäten. Die ConnectX-Karten bieten in der neusten Generation (ConnectX 6-Dx) bis zu 2 Ports mit 25, 50 oder 100 Gb/s sowie einen Port mit bis zu 200 Gb/s mit InfiniBand und Ethernet Konnektivität.

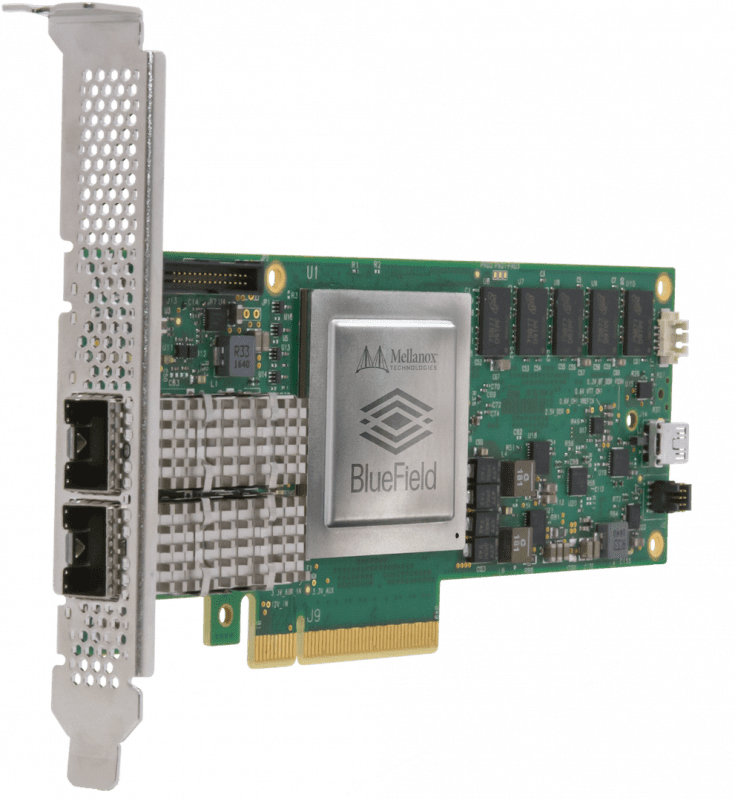

BlueField IPU SmartNICs

Die BlueField I/O Processing Units bieten die Fähigkeiten der ConnectX Netzwerkadapter in Kombination mit einem 64-bit Arm Multi-Core Prozessor und einem Hochleistungs-Memory Controller. Dies ermöglicht es Netzwerk-, Sicherheits- und Storage-Aufgaben auf den BlueField IPUs auszulagern.

Innova FPGA SmartNICs

Die Innova SmartNICs verfügen neben dem ConnectX-5 IC über eine zusätzlichen On-Board FPGA, der besonders für Verilog FPGA geeignet ist.

Switching

Alle Switching Produkte von Mellanox werden von umfangreichen Softwarelösungen unterstützt, die eine einfache und umfassende Verwaltung der Netzwerke ermöglichen.

Ethernet Switching

Die Switche der Spectrum und Spectrum-2 Serie überzeugen durch hohe Datenraten mit Portspeeds zwischen 1 Gb/s und 400 Gb/s und einem breiten Portfolio an Formfaktoren von 16 bis 128 Ports. Zusätzlich bieten die Switches viele Softwaretools für Administratoren, um die Switche für ihre Aufgaben vorzubereiten und die Verwaltung zu vereinfachen.

InfiniBand Switching

Die InfiniBand Switches sind auf hohen Datendurchsatz bei ultra-niedrigen Latenzen optimiert und sind daher besonders für High-Performance-Computing Rechenzentren geeignet. Die Switche bieten bis zu 200 Gb/s pro Port und können Latenzen von weniger als 90 ns unterstützen.

Kabel und Transceiver

Die LinkX Produktfamilie bietet Kabel und Transceiver für Cloud, HPC, Telco und Data Center Anwendungen. Mellanox bietet als einziges Unternehmen Interkonnektoren für Geschwindigkeiten von 10, 25, 40, 50, 100, 200, und 400 Gb/s an. Die Produkte sind für InfiniBand und Ethernetprotokolle, SFP-, QSFP- und OSFP-Formfaktoren und Distanzen zwischen 0,5 m und 10 km erhältlich. Alle Kabel und Transceiver werden in einer End-to-End Umgebung getestet und garantieren eine Bit Error Rate von weniger als 1E-15 und sind somit führend in der Branche.

Fragen? Fragen!

Ich bin Sebastian Wiedemann aus dem HCD Vertriebsteam. Ich berate Sie gerne oder helfe Ihnen bei Fragen weiter. Sie erreichen mich telefonisch unter +49 89 215 36 92-0 oder per Kontaktformular.

Jetzt beraten lassen

English

English